最近,AI芯片市场明显“冷”了下来。

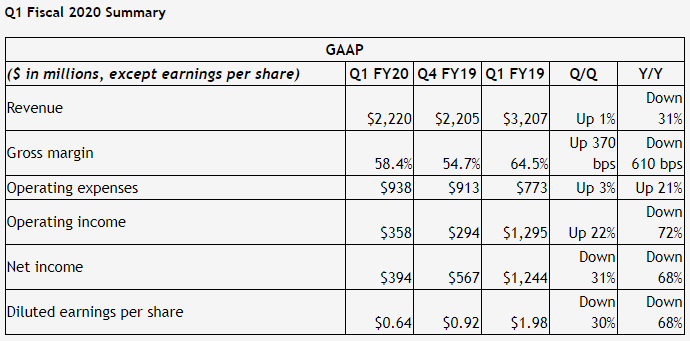

作为芯片市场的一哥,英伟达刚刚发布的Q1季度报告表现就十分不理想。数据显示,截至2019年4月28日,英伟达当季收入22.20亿美元,环比增长1%,同比下跌31%,毛利率58.4%,环比提高3.7个百分点,同比减少6.1个百分点;净利润3.94亿美元,环比下跌31%,同比下跌68%。数据一出,整个AI芯片市场的心态都很难不受影响。

英伟达营收下跌的因素有很多,作为高端芯片设计巨头,就像是早年苹果显著优势被不断追赶上一般,现在英伟达也处在这样的困局之中,创新无力,优势渐失。因此,它的利润下跌暗示出两个信号:1.整个市场平均水平上升了;2.高端AI芯片市场产品性能发展“停滞不前”。

可见,形势已然生变。

人人可做的AI芯片

从应用角度来看,AI芯片主要应用在云、边缘和端侧。其中云上最为常见的产品是AI加速器,其主要用于加速深度学习训练和推理;而在边缘和端侧,则根据在智能手机、安防、汽车等领域应用场景的不同出现各类AI芯片。其中云端训练需求大约占AI芯片市场的50%,云端推理需求约占AI芯片市场的25%,边缘和端侧占据25%。

数据显示,AI芯片市场规模在未来5年将会增长10倍,到2022年达到35亿美元,可以说是一个相当可观的市场。

但是入局者很多,尤其是在应用端,国内原本做安防、语音语义、人脸识别、云计算等领域解决方案的公司纷纷开始了自研芯片的道路,从百度、阿里到思必驰、云天励飞。而2018年大批AI算法公司开始转向各自所在领域的AI芯片研究,这也不再让人感到惊奇。

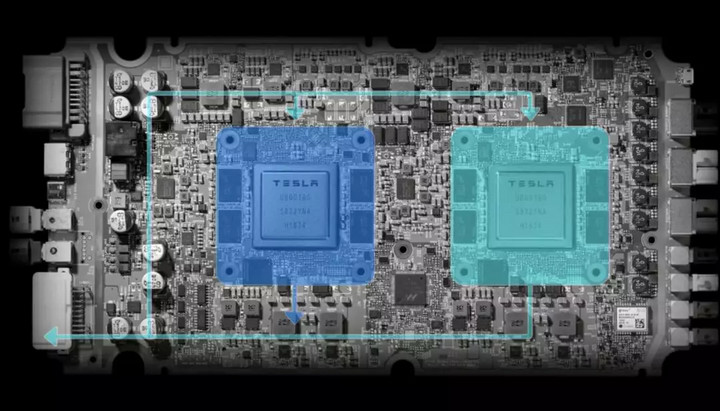

开先河的人是谁?似乎是特斯拉。大家应该都还记得,马斯克“嫌弃”英伟达芯片之后自己默默地就研发了用于自动驾驶的芯片,速度很快就换下了英伟达芯片,完全是一副“很容易做”的态势。

公开数据显示,截止2018年底,国内芯片设计公司规模已经发展到近1700家,虽然受经济影响,增速大不如前两年,但是仍然有不少人想要抢夺这块蛋糕。在AI的大背景下,人人可做芯片成为一个再正常不过的现象,这也让这部分尚未成型的市场争夺格外激烈。

2018年是格外热闹的一年,包括云知声、思必驰、出门问问等国内不少AI初创企业纷纷推出了自己的芯片或模组。而今年年初,云知声更是一口气发布了三款芯片:第二代物联网语音AI芯片雨燕Lite,面向智慧城市的支持图像与语音计算的多模态AI芯片海豚(Dolphin)以及面向智慧出行的车规级多模态AI芯片雪豹(Leopard);而思必驰也携手中芯国际发布AI语音芯片TAIHANG。如此之类,比比皆是。

可以看出,尤其是在终端应用上,芯片设计巨头的优势正在逐渐消失。

为什么AI芯片人人可做?

“做神经网络芯片并不难。”在刚刚结束的CAIS大会上,赛灵思人工智能业务资深总监姚颂公开表示。

言下之意,现在应用于深度学习算法的AI芯片开发起来并不是一件困难的事情。因为应用在特定领域,对于初创公司来说,专用架构设计已经没有太高门槛,早期的初创公司如寒武纪、地平线等公司也都已经开始比拼工程能力和客户能力。

那AI芯片到底为何如此容易做?

回答这个问题还需要回到AI芯片是什么这个话题上。

说起AI芯片,它是一个比较宽泛的概念,且至今为止都没有一个明确的定义。从广义范畴上讲,面向AI计算应用的芯片都可以称为AI芯片。除了以GPU、FPGA、ASIC为代表的AI加速芯片(基于传统芯片架构,对某类特定算法或者场景进行AI计算加速),还有比较前沿性的研究,例如类脑芯片、可重构通用AI芯片等。

但后者距离大规模商用还有较长距离,暂时不会对市场造成太大影响。因此一般情况下,当我们谈论AI芯片,我们通常指的是以GPU、FPGA、ASIC为代表的AI芯片,而它们本质上就是AI加速器或计算卡,即专门用于加速AI应用中的大量计算任务的模块(其他非计算任务仍由CPU负责)。

如业内人所分析,因AI芯片就是用于计算的芯片,效率高,功能相对单一,且不涉及IP授权问题,应用起来更节约资源且门槛要比通用芯片低,故而进场者众多。

当然,除了技术本身,AI芯片市场发展的停滞不前也为入局者留有了足够的时间。有业内人调侃说,“我去年把工作重心放在了5G,今年转回来去做AI芯片,发现还是没有多大变化。”

可以看出,门槛低、专用性强、AI芯片再难创新等因素都直接促使了AI公司纷纷去做自己的AI芯片。

官方微信:日成最新资讯

官方微信:日成最新资讯 移动官网

移动官网 官方商城

官方商城